Искусственный интеллект (ИИ) уже не фантастика — он стал частью нашей повседневной жизни. Мы доверяем ему выбор фильмов, анализ здоровья и даже финансовые решения. Но насколько безопасно передавать такие полномочия алгоритмам? Ответ прост: чтобы ИИ работал в интересах общества, нужны четкие правила и принципы. Именно здесь на сцену выходит этика ИИ — набор норм, который помогает избежать ошибок и несправедливости.

В этой статье мы рассматриваем важность этических норм, принципов в разработке и использовании искусственного интеллекта. Также рассматриваются основные принципы этики ИИ, такие как прозрачность, ответственность, справедливость и безопасность, а также их влияние на разные сферы, включая медицину, финансы и правосудие.

Основное внимание уделено вопросам, как он должен принимать решения, чтобы не нарушать права людей, избежать предвзятости и ошибок, а также обеспечить понимание процессов, лежащих в основе алгоритмов. Статья объясняет, как эти принципы помогают создавать более безопасные и справедливые технологии, а также подчеркивает важность соблюдения этих норм для повышения доверия и минимизации рисков, связанных с использованием ИИ.

Что же это такое?

Этика ИИ — это свод правил и принципов, которые определяют, как искусственный интеллект должен принимать решения. Представьте, что ваш домашний робот решает, какие продукты покупать, и неожиданно отказывается от сладостей. Неприятно, правда? Эти правила помогают ему учитывать интересы людей и работать без предвзятости.

Эти правила особенно важны в таких сферах, как:

- Финансы. Алгоритмы должны принимать решения о кредитах справедливо, без дискриминации по возрасту или полу.

- Медицина. Ошибки при постановке диагнозов могут стоить жизни, поэтому важно, чтобы он работал на основе достоверных данных.

Почему этика ИИ важна?

Без этических норм ИИ может допускать серьезные ошибки. Например:

- Алгоритмы могут неправильно обрабатывать данные, что приведёт к несправедливым и неправильным решениям.

- Возможна дискриминация: ИИ может основываться на стереотипах, если его не обучить правильно.

- Судебная несправедливость: Алгоритм в США давал завышенные оценки риска повторных преступлений для афроамериканцев, что приводило к более суровым наказаниям.

- Дискриминация в кредитах: Женщинам предлагали меньшие кредитные лимиты, чем мужчинам, даже если их финансовое положение было одинаковым.

Примеры реальных ошибок искусственного интеллекта без этических норм:

- Ошибка с фотографией паспорта в Новой Зеландии

- Алгоритм распознавания лиц отказал в приёме фотографии Ричарда Ли из-за «закрытых» глаз, хотя они были открыты. Это связано с некорректной работой алгоритма на лицах азиатской внешности, что вызвало критику из-за предвзятости системы.

- Медицинские ошибки IBM Watson

- Медицинский суперкомпьютер Watson от IBM давал опасные рекомендации по лечению рака. Это происходило из-за обучения на синтетических данных, а не на реальных клинических случаях, что приводило к неверным выводам и рисковало жизнями пациентов.

- Галлюцинации нейросетей

- Например, чат-боты предлагали несуществующие законы или давали выдуманные ответы на запросы пользователей. Это вызвало путаницу среди пользователей и могло привести к использованию ложной информации в судебных разбирательствах.

- Неверные данные от чат-ботов: Чат-бот компании Air Canada предоставил клиенту ложную информацию о политике возмещения расходов на поездки, что привело к судебному разбирательству. В итоге компания была признана виновной в распространении недостоверной информации

Эти примеры показывают, что отсутствие этики и контроля в работе может привести к дискриминации, рискам для здоровья и даже финансовым убыткам. Поэтому важны прозрачность, ответственность и справедливость при разработке и использовании искусственного интеллекта.

Основные принципы этики ИИ

Для работы в интересах людей важны несколько ключевых принципов: Прозрачность, Ответственность и Справедливость. Кодекс этики в сфере ИИ требует, чтобы работа ИИ была открытой и прозрачной.

Прозрачность один из главных управляющих принципов, который обеспечивает открытость и понятность работы алгоритмов для пользователей и регулирующих органов.

2. Ответственность. Люди, которые разрабатывают и используют ИИ, должны брать на себя ответственность за ошибки, сделанные системой. Если алгоритм принимает неправильные решения, это вина разработчиков или компании.

3. Справедливость означает, что ИИ должен принимать решения без предвзятости. Он не должен основывать свои решения на таких факторах, как возраст, пол, раса или другие личные характеристики. Справедливость помогает обеспечить равные возможности для всех людей.

Важно: ИИ не должен дискриминировать пользователей по возрасту, полу или другим признакам. Алгоритмы обязаны учитывать только объективные факторы и предоставлять равные возможности всем. Это закреплено в национальном кодексе этики ИИ.

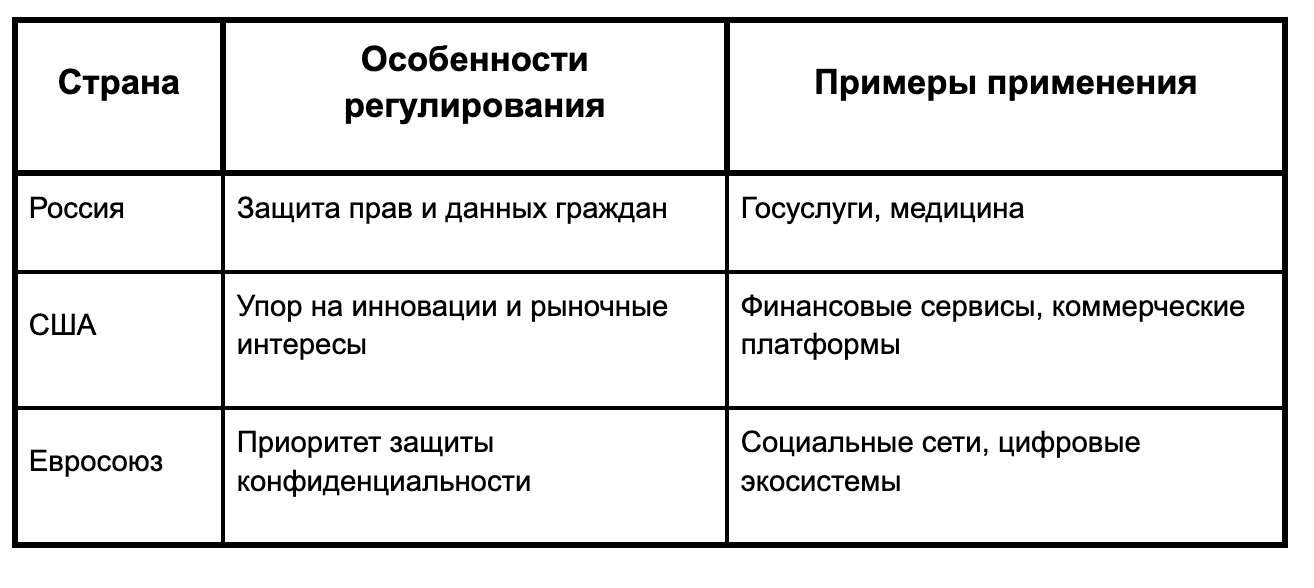

Как этика ИИ реализуется в разных странах?

Специалист по этике ИИ — это эксперт, который следит за тем, чтобы системы искусственного интеллекта работали в соответствии с моральными, юридическими и социальными нормами. Его главная задача — обеспечить безопасность, прозрачность и справедливость решений, принимаемых ИИ.

Где в России обучиться по специальности «Специалист по этике ИИ»

Заключение

Этика ИИ — это не просто набор правил, а комплексный подход, который требует междисциплинарного сотрудничества между разработчиками, исследователями, законодателями и обществом в целом. Важно, чтобы технологии развивались с учетом этических норм, что позволит избежать потенциальных проблем и использовать ИИ для решения актуальных социальных и экономических задач. Этические принципы могут стать основой для создания более безопасного и справедливого будущего, в котором ИИ служит интересам человечества.